With the eyes of a machine — Making of

Building a machine learning system

Rund zwei Wochen lang haben sich Sebastian und Fabian die Abende im Lab um die Ohren geschlagen, um unsere KI-Anwendung rechtzeitig zur Langen Nacht der Wissenschaften fertig zu stellen. Im Gespräch geben die beiden einen Einblick in den Entwicklungsprozess, den aktuellen Stand der Künstlichen Intelligenz und unerwartete Überraschungen bei der Zweckentfremdung von Thermodruckern.

Erinnert ihr euch noch, wie die Idee zur Anwendung entstanden ist?

Sebastian: Künstliche Intelligenz ist ein Thema, mit dem wir uns in den vergangenen Monaten bei der Stiftung intensiver beschäftigt haben. Zur Langen Nacht der Wissenschaften wollten wir ein Projekt machen, das dieses Thema auch für Laien anschaulich vermittelt. Das Thema Gesichtserkennung hat sich dafür angeboten. Unser Ziel war es, Besucher*innen dafür zu sensibilisieren, was heute bereits möglich ist, um so mit ihnen ins Gespräch zu kommen. Am Stand gibt es dann über unsere Flyer noch weitergehende Informationen über verschiedene Anwendungsszenarien der KI.´

Fabian, Du hast das Designkonzept gemacht. Worauf hast Du dabei Wert gelegt?

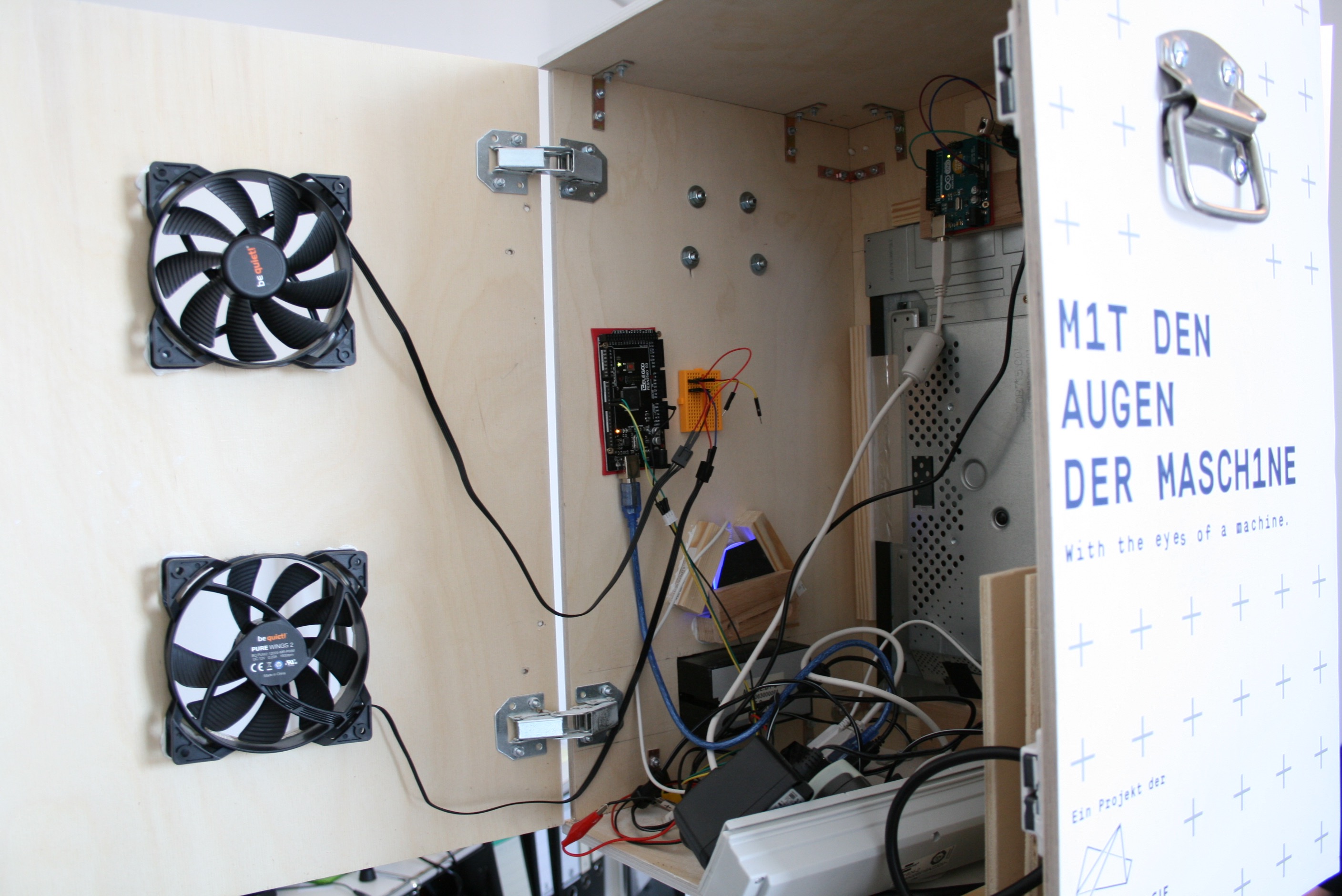

Fabian: Na, vor allem sollte es gut aussehen (lacht). Wir haben uns einerseits an einer Sci-Fi-Ästhetik orientiert, gerade weil sich solche Anwendungen immer noch nach einer Zukunftsvision anfühlen. Dabei ist die Pointe ja gerade, dass KI und Gesichtserkennung längst Realität sind. Deshalb ist es auch ein schöner Kontrast, dass unser eher futuristisches Interface in einer selbst zusammengezimmerten Holzkiste steckt, was den DIY-Aspekt des ganzen unterstreicht. Auch die Schwarz-Weiß-Portraits aus dem Thermodrucker haben eher so einen Lo-Fi-Look.

Was steckt denn jetzt alles in der KI-Fotobox?

Sebastian: In der Kiste versteckt sich zunächst mal ein Laptop mit Internetzugang und ein Monitor ohne Gehäuse (den wir aus unserem Magic Mirror geborgt haben). Die Navigation funktioniert über einen ins Gehäuse eingelassenen Touch-Button. Zwei Arduinos steuern außerdem das LED-Blitzlicht an der Webcam und den Thermodrucker. Auf der Rückseite sorgen zwei Lüfter für Kühlung. Softwareseitig läuft die Anwendung im Browser, ein Node.js-Backend kümmert sich um die Druckersteuerung und die API-Kommunikation. Die eigentliche Gesichtserkennung wird dann in der Cloud über die Azure Face-Recognition-API von Microsoft erledigt.

Wie waren eure Erfahrungen mit der Verwendung dieser API? Ist das kompliziert?

Sebastian: Nein, überhaupt nicht. Das komplizierteste war, die AGBs durchzulesen (lacht). Denn für uns war wichtig, dass die Daten unserer Besucher*innen in Europa verarbeitet und nach der Verwendung auch wirklich wieder gelöscht werden. Aber technisch ist es inzwischen wirklich einfach. Die Systeme der großen Anbieter sind natürlich auch entsprechend trainiert, das hätten wir nicht selbst leisten können, weil wir solche Trainingsdaten gar nicht haben. Wir haben alle möglichen Tests gemacht (verschiedene Hauttypen, Frauen/Männer, Haare/keine Haare) und waren mit den Ergebnissen recht zufrieden.

Was hat es mit dem erwähnten Thermodrucker auf sich?

Fabian: Wir wollten, dass die Besucher*innen etwas mit nach Hause nehmen können, deshalb wird das fotografierte Portrait nach der Erkennung ausgedruckt. Den Thermodrucker fanden wir witzig, weil er eine sehr rauhe, maschinenhafte Ästhetik hat und es so ein bisschen wirkt, als ob man von der Maschine „abgefertigt“ wird wie ein Produkt. Solche Drucker werden ja sonst an der Supermarktkasse für Kassenbons genutzt. Technisch war das aber knifflig, weil diese Drucker für den Druck von Text gemacht sind und Bilddateien etwas mehr Speicher benötigen. Wir haben also ein paar Tage gebraucht, um das Datenhandling so in den Griff zu kriegen, dass der Drucker sich nicht ständig aufhängt.

Wie war allgemein euer Eindruck von der Leistungsfähigkeit der KI?

Sebastian: Insgesamt funktioniert die Gesichtserkennung schon ziemlich gut. Natürlich fallen einem trotzdem hin und wieder Eigenheiten auf. zum Beispiel erfassen wir in dem Projekt ja auch den Gesichtsausdruck, also ob jemand eher fröhlich, traurig oder wütend schaut. Und unser Eindruck war, dass die KI ältere Menschen häufiger als verärgert einschätzt. Das funktioniert übrigens auch umgekehrt: Wenn man wütend guckt, schätzt die Maschine einen älter. Empirisch belegen können wir das aber nicht (lacht).

Fabian: Es ist ja schon so, dass sich das meiste hinter der Oberfläche der KI abspielt. Es lässt sich dann tatsächlich kaum nachvollziehen, wie die Maschine solche Dinge entscheidet. Das hat natürlich auch einen problematischen Aspekt. Umgekehrt kann man aber eben auch die Vorteile der KI nutzen, ohne sich mit allen Details auseinandersetzen zu müssen.

Ihr habt ungefähr zwei Wochen an dem Projekt gearbeitet. Wenn ihr jetzt nochmal von vorne anfangen könntet, was würdet ihr anders machen?

Sebastian: Abgesehen von ein paar Anfängerfehlern bei der Holzarbeit hat eigentlich alles prima geklappt. Nur die Sache mit dem Thermodrucker würden wir uns rückblickend vielleicht nochmal überlegen. Das hat einige Nerven gekostet. Der Rest war eigentlich easy.